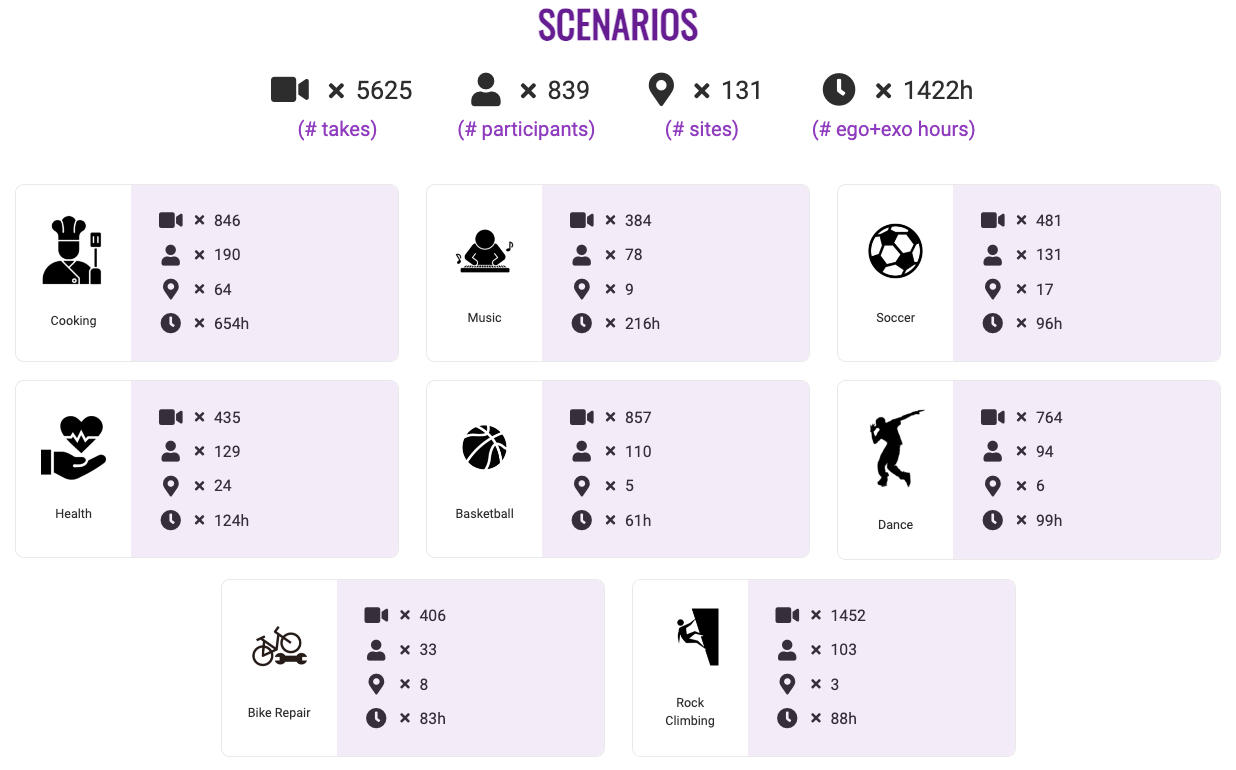

메타가 1,422시간 이상의 분량의 인간 활동을 영상으로 기록한 이고-엑소4D(Ego-Exo4D)를 발표했다. 이고-엑소4D는 839명의 참가자가 전 세계 13개 도시에서 일상적인 생활 속에서 활동하는 '숙련된 사람의 행동'을 다채널 영상과 오디오로 담아낸 멀티모달, 멀티뷰, 비디오 데이터 세트로, AI를 위한 비디오 학습 및 다중 모드 인식에 활용할 수 있는 요긴한 자료다.

이고-엑소4D는 요리, 음악, 축구, 건강, 농구, 춤, 자전거 수리, 암벽 등반을 하는 사람과 주변에 카메라를 설치하고 다양한 각도에서 인간의 활동을 기록했다. 사람은 안경 형태의 웨어러블 카메라를 이용해 현재하고 있는 행동을 1인칭 시점에서 기록한 자기중심적(egocentric)인 영상을 촬영하도록 했고, 사람 주변에 설치한 여러 대의 카메라로는 주변상황(exocentric)을 촬영했다.

이러한 두 가지 시점을 다양한 각도의 영상으로 촬영함으로써, 행동하는 사람이 보고 듣는 자기중심적 영상과 그런 사람 주변의 공간과 변화 상황을 기록한 것이다. 이를 통해 복잡하고 다양한 변수가 존재하는 인간의 활동을 새로운 시각과 효율적인 방법으로 AI에게 학습시킬 수 있다. 데이터 세트는 2023년 12월 말 이전에 공개될 예정이다.

사람이든 AI든 '똑똑한 존재'는 태어나는 것이 아니라 만들어지는 것이다. 아무리 머리가 좋아도 모든 것을 저절로 알 수는 없다. 배운 것이 없다면 아는 것이 있을 수 없고, 그래서 지식과 경험이 반드시 필요하다. 사람에게는 좋은 책이 AI에게는 좋은 데이터 세트가 필요한 이유다. 이고-엑소4D는 하루가 다르게 일취월장하는 다양한 AI 모델에게 사람의 지식과 경험을 전수할 수 있는 더없이 좋은 자료다.

요리 데이터 세트에는 190명의 사람이 전 세계 64개의 장소에서 기록한 846개의 동영상으로 이루어진 654시간 분량의 영상이 담겨 있다. 음악 데이터 세트는 78명의 사람이 전 세계 9개의 장소에서 담아낸 384개의 동영상으로 구성된 216시간 분량의 비디오로 이루어져 있다. 축구 데이터는 131명의 사람이 전 세계 17개의 장소에서 촬영한 481개의 동영상으로 96시간의 활동을 기록했다.

건강 데이터 세트는 129명이 전 세계 24개의 장소에서 담아낸 124시간 동안의 435개 비디오, 농구는 110명이 전 세계 5개의 장소에서 857개의 동영상으로 61시간의 활동을 녹화했다. 춤은 94명이 전 세계 6개의 장소에서 764개의 비디오로 99시간의 활동을 촬영했고, 자전거 수리는 33명이 406개의 비디오로 83시간, 암벽등반은 103명이 1,452개의 동영상을 촬영해 88시간의 활동을 기록했다.

이렇게 실제 사람의 활동을 기록한 데이터는 앞으로 AI 모델을 개발하고 발전시키는 데 활용할 수 있는 소중한 자료로 활용된다. 따라서 행동 내용이나 단계 인식, 사람의 숙련도 추정, 자세 추정, 공간 인식, 사물 식별이나 관계 확인 등 멀티모달 AI의 학습에 다양한 방법으로 활용할 수 있을 전망이다.

이고-엑소4D는 메타의 FAIR(Fundamental Artificial Intelligence Research; 인공지능 기초 연구)와 아리아(Aria) 프로젝트, 15개 대학 파트너가 2년 동안 노력한 결과물이다. AI 모델 학습을 위해 인위적으로 만들어낸 합성 데이터가 아니라, 엄격한 개인정보보호 및 윤리 정책과 많은 참가자들의 노력으로 실제 생활과 행동을 기록하고 수집한 영상 데이터라는 점에서 가치와 의미가 남다르다.

메타는 "이고4D(Ego4D)는 대본에 없는 일상 활동을 수집했다. 반면에 이고-엑소4D는 숙련된 활동에 중점을 두어 다양한 기술 수준의 참가자가 동일한 시나리오를 수행하는 것으로 기록되도록 하면서, 새로운 환경에서 수행되는 시나리오에 자연스러운 구별을 유지하도록 했다. 우리는 절차적 활동과 신체적으로 숙련된 활동을 모두 다룬다"며 이고4D(Ego4D)와 이고-엑소4D가 다른 점을 설명했다.

이고-엑소4D는 시간이 동기화된 1인칭 및 3인칭 비디오의 최대 공개 데이터 세트로 구성되며, ►카메라 착용자가 자신의 행동을 설명하는 1인치 설명 ►카메라 착용자의 모든 행동에 대한 3인칭 실황 설명 ►전문가들이 카메라 착용자의 자세, 행동 등에 대한 설명으로 구성된 데이터가 함께 제공된다. 단순한 멀티뷰(MutiView) 영상이 아닌 멀티모달(MultiModal) 데이터 세트인 것이다.

영상 제작에는 1인칭 시점의 영상 촬영에 웨어러블 안경인 아리아(Aria), 주변 상황 촬영에 고프로와 광각 흑백(Gray Scale) 카메라 등을 사용했다. 모든 동영상과 7개 채널의 오디오는 시간에 동기화되어 있으며, 참가자의 활동을 방해하지 않고 유용한 시점을 최대한 촬영할 수 있도록 주변에 배치되는 카메라의 수와 배치는 시나리오를 통해 결정했다.

⧉ Syndicated to WWW.CIOKOREA.COM

'🅣•TREND•TECHNOLOGY > ARTIFICIAL INTELLIGENCE' 카테고리의 다른 글

| '탭 정리, 맞춤 테마, 글쓰기 도움'...구글, 크롬에 AI 도움 3가지 기능 실험 (0) | 2024.01.27 |

|---|---|

| "두뇌를 명령이 아닌 대화 모드로 재설정"...MS, 'AI 활용 습관 5가지' 제안 (0) | 2024.01.16 |

| 엣지 AI 시장 2028년까지 30.5% 성장 전망...엣지 컴퓨팅 & AI 기술 채택 증가 (0) | 2023.12.20 |

| 문서 업로드하고 질문하면 AI가 척척 답변...구글 '노트북LM', 정보 유출 염려없이 보고서 요약 & 메모 (0) | 2023.12.14 |

| "인간 전문가를 능가하는 생성 AI 모델"...구글, 멀티모달 생성 AI 모델 '제미나이' 공개 (0) | 2023.12.08 |

| '사람처럼 자연스럽게, 거의 실시간 번역'...메타, 심리스 커뮤니케이션 모델 공개 (0) | 2023.12.06 |

| '생성 AI가 주당 5시간 절약'...세일즈포스, AI가 변화시킬 업무의 미래 예측 (0) | 2023.11.24 |

| AI가 음악 창작의 새로운 시대연다...구글 딥마인드, AI 기반 음악 도구 공개 (0) | 2023.11.24 |