낫 놓고 기역 자를 알려면, 낫도 알아야 하고, 기역도 알아야 한다. 어느 한쪽만 알아서 될 일이 아니다. 요즘처럼 세상이 빨리 많이 넓게 변하는 세상에서는, 무엇인가를 알기 위해 알고 있어야 하는 사전 지식이 훨씬 많이 필요하다. 기술만 아는 우물 속에 살면서, 낫으로 할 수 있는 일은, 풀이나 벼를 베는 일뿐이다. 예술만 아는 동굴 속에 살면서, 기역으로 할 수 있는 일은, 그저 벽에다 기역을 그리는 것뿐이다.

둘 다 알아야 우물과 동굴에서 나올 수 있고, 우물과 동굴을 벗어나야 낫도 기역도, 쓸모가 많아지고 새로운 의미가 된다. 그래서 요즘 같은 세상에서는 많이 아는 것이 뇌와 몸을 지혜롭게 쓸 수 있는 지름길이다. 모르는 것이 약이 되는 경우가 없는 것은 아니지만, 아는 것이 힘이 되는 경우가 더 많은 세상이다. 세상에 몰라도 되는 것은 그리 많지 않다. 많이 알면 뇌도 몸도 편해지고 즐거워진다, 여기 구글 실험실이 진행하는 두 가지 프로젝트가, 바로 그런 좋은 사례에 해당한다.

런웨이 팔레트(Runway Palette)와 리빙 아카이브(Living Archive)는 패션과 무용을 인공지능과 결합해, 패션을 예술과 데이터 과학의 경계로 올리고 무용을 전문가의 예술에서 일상의 생활로 바꿔주는 프로젝트다. 두 가지 프로젝트의 핵심은 AI(artificial intelligence)와 ML(machine learning)이다. 과학과 기술에만 관심이 있는 사람이라면 전혀 가까이 갈 일이 없는 패션과 무용, 패션과 무용을 업으로 삼는 사람이라면 눈길조차 줄 일이 없는 인공지능과 기계학습. 두 분야의 전문가의 협업으로 새로운 세상을 여는 프로젝트다.

구글의 아트 앤 컬처 랩(Art & Culture Lab)은 예술과 기술의 관계를 탐구하고 이를 융합하는 시도를 하고 있다. 2012년부터 다양한 분야의 아티스트와 협력해 지속해서 다양한 프로젝트를 수행하며, 새롭고 독창적인 기술과 예술의 만남을 선보이고 있다. 이번에는 인공지능의 능력을 활용해 패션과 무용의 지경을 넓히는 실험을 시도했다. 런웨이 팔레트는 패션쇼를 색상 기반의 데이터로 만들었고, 리빙 아카이브는 무용 동작을 아카이브로 만들어 누구나 활용할 수 있도록 했다.

런웨이 팔레트는 4년 동안 약 4,000여 개의 패션쇼에서 촬영한 사진을, 기계학습 과정을 통해 색상 팔레트로 구성해 데이터베이스로 만들었다. 2D 또는 3D로 구현되는 색상 팔레트에서 원하는 색상 블록을 선택하면, 해당 색상으로 분류된 사진 목록으로 이동하고, 디자이너나 계절 트렌드 별 패션 코드를 한눈에 확인할 수 있다.(사진:런웨이 팔레트 캡처)

런웨이 팔레트는 패션쇼에서 수집한 방대한 사진을 기반으로, ‘색상’을 일종의 검색 키워드처럼 색인화한 것이다. 단어로 된 색상이 아니라, 시각적으로 표현된 실제 색상을 선택하면, 이와 관련된 색상 집합으로 이루어진, 패션쇼 사진을 검색해 보여주는 솔루션이다. 색상에 따라 데이터를 분류하는 작업에는 인공지능의 기계학습 능력을 활용했다. 시각화 작업은 BoF(Business of Fashion)와 공동으로 2015-209년까지의 패션쇼 자료를 사용했다.

약 4,000여 개의 패션쇼에서 촬영한 14만 개의 사진을 수집하고, 각 사진에서 주요 색상을 추출한 후, 이를 기계학습 과정을 거쳐 색상 팔레트로 이미지를 구성했다. 하루에 한 번 씩 패션쇼에 참석한다고 가정하면 약 10년 이상 걸리는 패션쇼 데이터를 활용한 셈이다. 이렇게 색상 팔레트로 구성된 이미지를 대화형으로 시각화해, 원하는 색상 팔레트를 선택하면, 관련된 사진을 보여주는 방식으로 구현했다. 이렇게 구성된 팔레트는 4년간 1000여 명의 디자이너가 실험에 참여하며 사용했다.

런웨이 팔레트 페이지에 접속하면 수많은 색상의 점으로 구성된 팔레트를 만날 수 있다. 팔레트는 2D 또는 3D로 볼 수 있다. 색상 팔레트에서 원하는 색상 블록을 마우스로 선택하면, 해당 색상으로 분류된 패션쇼 사진 목록으로 바로 이동한다. 사진 썸네일 목록에서 다시 원하는 사진을 선택하면, 디자이너 이름과 어느 패션쇼 또는 어느 시기에 촬영한 사진인지에 대한 정보가 표시된다.

이렇게 색상 팔레트로 시각화한 데이터를 활용해, 전 세계 패션 위크에서 나오는 색상, 디자이너, 계절 및 트렌드를 탐색할 수 있다. 따라서 2017년 가을에는 어떤 색상이 유행했는지, 그때 디자인 트렌드는 어떠했는지를, 또 다른 형태의 패션쇼를 보는 것처럼 편리하고 쉽게 알아볼 수 있다. 만약 인공지능의 도움이 없었다면, 이러한 방법으로 패션 데이터를 분류하는 것이 가능했을까 하는 생각을 갖게 될 정도로, 방대한 데이터와 시각화해서 데이터로 만든 색상 정보가 돋보이는 프로젝트다.

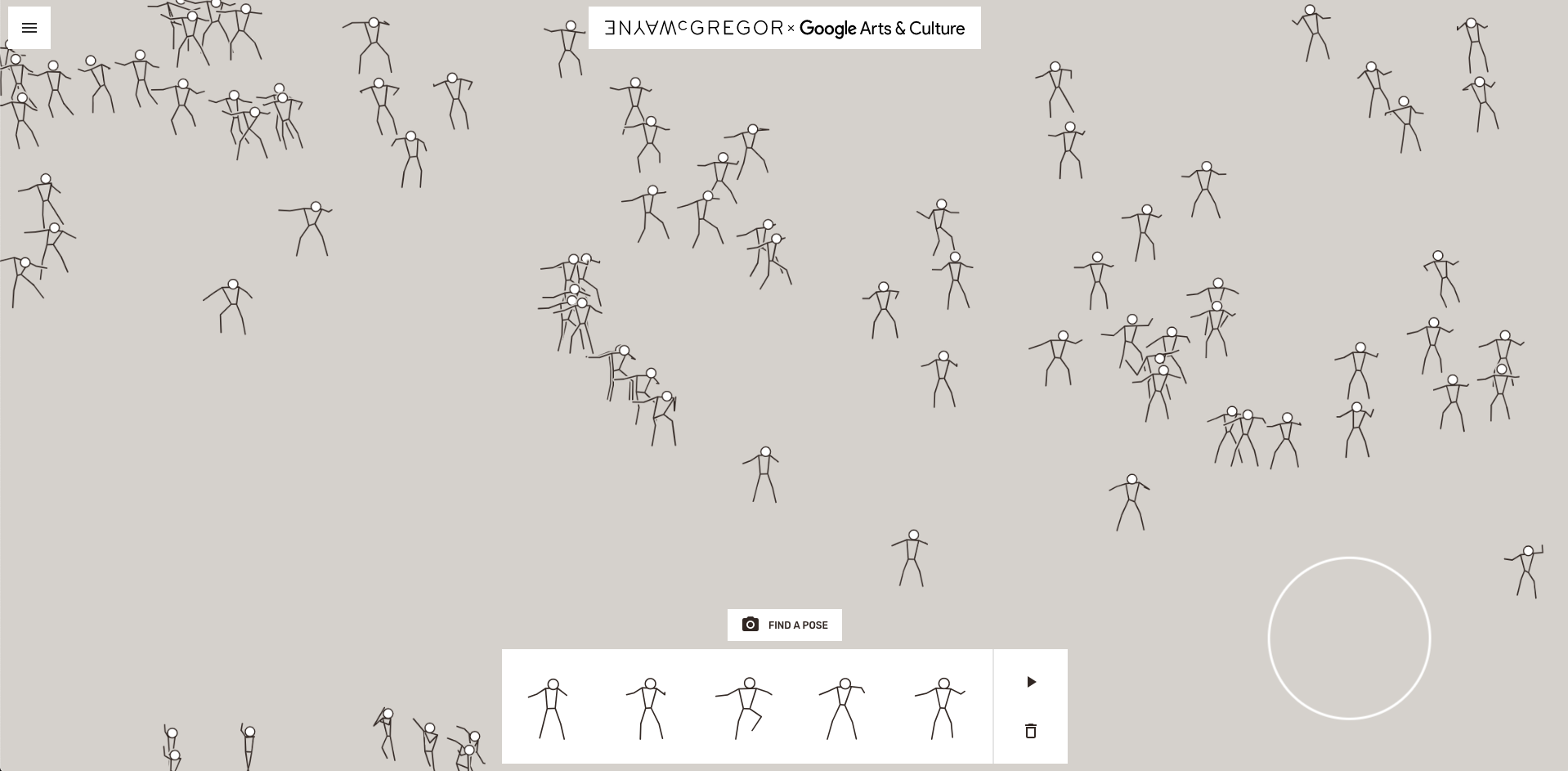

영국의 안무가 웨니 맥그리거가 25년 동안 활동하며 기록한 안무 기록에서 100시간 이상의 춤 동작을 기계학습으로 분석한 후, 웨니의 안무 동작을 예측해 약 50만 개의 안무 동작을 만들었다. 누구나 홈페이지에서 안무 동작을 골라 선택한 후, 이를 연결해 새로운 안무를 창작하는 데 활용할 수 있다.(사진:리빙 아카이브 캡처)

리빙 아카이브는 영국의 유명 안무가인 웨니 맥그리거(Wayne McGregor)와의 협업을 통해 이루어진 인공지능 기반의 안무 도구다. 25년 이상 축적한 웨니의 안무 자료에서 100시간 넘는 무용 공연을 기계학습을 이용해 학습하고 분석한 후, 웨니의 춤추는 스타일로 동작을 예측해 안무 동작을 생성한다. 이렇게 생성한 데이터를 올해 7월 LA 뮤직센터에서 초연된 새로운 작품을 창작하는 데 사용하기도 했다.

리빙 아카이브 페이지를 방문하면 이렇게 생성된 안무를 누구나 직접 체험하고 활용해 볼 수 있다. 홈페이지에 접속한 후 ‘당신 만의 안무 만들기(Create your own dance)’ 창에서 시작(GET STARTED) 버튼을 마우스로 클릭한다. 안무 만들기 페이지가 열리면, 다양한 동작을 취하고 있는, 단순화한 안무 이미지를 만날 수 있다.

마우스를 이용해 화면에 있는 커다란 동그라미를 움직이면, 각각의 안무 동작을 자세하게 볼 수 있다. 이러한 방법으로 적당한 안무 동작을 찾으면, 왼쪽 마우스 버튼을 클릭해서 선택한다. 이렇게 선택된 안무는 아래쪽 화면에 순서대로 저장된다. 모든 동작을 선택했으면, 오른쪽에서 삼각형 모양의 실행 버튼을 누른다. 그러면 지금까지 선택한 개별적인 동작을 연속으로 이어서, 연결된 춤 동작으로 볼 수 있다.

데이터 베이스에서 마땅한 동작을 찾을 수 없다면, 직접 노트북이나 스마트폰 카메라를 이용해, 자신의 원하는 안무 형태를 입력할 수도 있다. 이때는 화면 아래에 있는 카메라 아이콘을 누른 후, 원하는 자세를 취하고 사진으로 촬영하면 된다. 리빙 아카이브에서 검색할 수 있는 안무는 약 50만 건으로, 이러한 데이터베이스와 자신의 안무를 캡처하는 방법을 조합하면, 빠르고 간편하게 다양한 안무 동작의 창작이 가능해진다.

인공지능을 개발하고 개선하고 발전시키는 것은 ‘과학’과 ‘기술’의 영역이다. 하지만 그것을 적용하고 활용하고 응용하는 것은 ‘창작’과 ‘예술’의 영역에 가깝다. 개발과 발전은 과학자와 기술자의 몫이지만, 그것을 실제로 활용하는 것은 생활과 예술의 영역이라는 얘기다. 인공지능이나 머신러닝 같은 기술이 남의 얘기가 아니라는 뜻이다. 알아도 하지 않는 것과 몰라서 못하는 것은 전혀 다른 세상을 만든다. 기술이 현실과 만나면 ‘편리한’ 세상을 열고, 기술이 예술과 만나면 ‘즐거운’ 세상이 열린다.

'🅣•TREND•TECHNOLOGY > ARTIFICIAL INTELLIGENCE' 카테고리의 다른 글

| 알파벳 26자에 담아낸 AI 이야기…구글, OII와 협력해 초보자용 'AI 가이드' 제작 (0) | 2020.03.30 |

|---|---|

| 인공지능을 재난과 재해 대응에 활용...미국 적십자사의 미씽 맵 프로젝트 (0) | 2020.01.08 |

| AI로 유방암 진단 정확성 높인다...딥마인드, 오진율 줄인 '유방암 진단' AI 모델 (0) | 2020.01.03 |

| ‘음성’ 의료 기록 ‘문자’로 변환…아마존, 의료용 자동 음성 인식 기능 출시 (0) | 2019.12.11 |

| 인텔, AI 전용 주문형 반도체 NNP와 VPU 공개...클라우드 및 엣지 AI 시스템 본격 공략 (0) | 2019.11.13 |

| 누구나 활용하는 웹기반 머신 러닝 툴…구글, 티처블 머신 2.0 공개 (0) | 2019.11.08 |

| 우편 데이터 처리 10배 빠르고 정확하게…엔비디아, USPS에 AI 기술 제공 (0) | 2019.11.06 |

| 연산능력 100 AI 페타플롭스 슈퍼컴…MIT 링컨 연구소, AI 특화된 TX-GAIA 구축 (0) | 2019.10.01 |