엔비디아가 단일 카메라를 이용한 2D 이미지에 DNN(Deep Neural Network)을 적용해, 정확하게 거리를 예측하는 연구 결과를 공개했다. 인공신경망(Artificial Neural Network)을 이용한 머신 러닝에는 다양한 방법이 존재하는데, 이번 연구에는 DNN(Deep Neural Network)과 컨볼루셔널 신경 네트워크(convolutional neural networks)를 적용했다.

사람이 사물까지의 거리를 비교적 정확하게 예측할 수 있는 것은 두 개의 눈을 가지고 있기 때문이다. 양쪽 눈에 들어온 고행 상도의 시각 정보를 뇌에서 정확하게 동기화시킬 수 있기 때문에 거리 예측이 가능하다. 이를 인공적으로 구현하려면 역시 두 개의 카메라를 사용해, 카메라로 촬영한 영상 정보를 정확하게 동기화시켜 분석하는 작업이 필요하다. 하지만 두 개의 영상 정보가 정확하게 동기화되지 않으면 거리 예측에 오차가 생기게 된다.

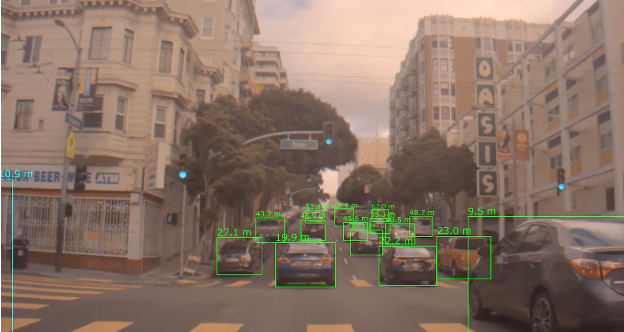

하나의 카메라로 촬영한 2D 영상을 DNN과 컨볼루셔널 신경네트워크를 활용해 학습시키면, 다양한 도로 환경에서 다른 자동차나 보행자와의 거리를 예측하고 추정하는 데 정확도를 높일 수 있다.(동영상:엔비디아 블로그)

하나의 카메라만을 사용할 경우는 이러한 작업을 수행할 수 없는, 2D 형태의 이미지만 생성된다. 따라서 단일 카메라를 장착한 시스템이나 자율주행 자동차에서는 ‘보는 것’만으로는 정확하게 거리를 예측하거나 측정할 수가 없다. 그래서 자율자동차에서는 거리를 측정하기 위해 전자파를 이용하는 레이다(Radar)와 레이저를 활용하는 라이다(LiDar)의 도움을 받는다.

레이다는 특정 주파수의 전자파를 조사한 후, 사물에 부딪혀 반사되어 돌아오는 신호를 분석한다. 이를 통해 목표물까지의 거리, 방향, 속도 등을 측정한다. 카메라가 사물을 촬영하고 이미지로 만들기 힘든 상황에서, 정확한 3차원 정보를 얻을 수 있다. 라이다는 눈에 보이지 않는 레이저를 이용해, 주변 환경을 실시간으로 스캔해, 어두운 환경에서도 보행자, 도로 조건, 건물 등의 3차원 정보를 수집한다.

자율주행 자동차에서 하나의 카메라를 이용해 물체와의 거리를 예측할 때, 일반적으로는 주행 중인 도로가 평지라고 가정하고 예측 과정을 수행하게 된다. 이러한 가정 아래에서 카메라로 촬영한 2차원 이미지를 활용해, 3차원 공간에서의 거리를 추정하는 방식을 사용했다. 하지만 이동 중에 만나게 되는 환경은 언덕이나 내리막길 등 다양한 형태의 도로 조건이 존재한다.

이런 이유로 정확한 거리를 예측하는 것이 어렵다. 다른 자동차나 보행자와의 거리가 정확하지 않다는 것은, 안전한 주행을 할 수 없다는 뜻이기도 하다. 정지하거나 속도를 줄여야 하는 상황에서 그대로 진행할 수도 있고, 긴급 제동하지 말아야 할 상황에서 거꾸로 급정거하는 오작동을 일으킬 수 있기 때문에 다양한 문제를 초래할 수 있다.

하지만 하나의 카메라로 촬영한 이미지를 분석하는 과정에서, 심층 신경네트워크와 컨볼루셔널 신경네트워크를 활용하면, 거리 예측 정확성을 향상 시킬 수 있다는 것이 엔비디아의 설명이다. 레이더 및 라이더를 이용해 수집한 데이터를, 심층 신경네트워크와 컨볼루셔널 신경네트워크 기법으로 학습시키면, 다양한 도로 조건에서 단일 카메라를 이용한 영상으로 거리 예측을 더욱 정확하게 수행할 수 있다.

물론 자율주행 시스템에서 카메라만으로 위치를 계산하고 예측하지는 않는다. 하지만 레이더와 라이더와 더불어, 카메라로 촬영한 영상으로 예측한 거리 정확도가 향상되면 자율주행 안정성과 정확도는 그만큼 높아진다. 따라서 DNN 기반의 거리 및 사물 인식과 예측은, 속도 제어부터 방향 전환 등에 카메라의 영상과 함께 활용되어, 복합적인 성능 향상을 가져올 수 있다고 엔비디아는 밝혔다.

'🅣•TREND•TECHNOLOGY > ARTIFICIAL INTELLIGENCE' 카테고리의 다른 글

| 머신러닝으로 학습한 AI가 산림 보호...아웃랜드 애널리틱스, 산림 감시 시스템 개발 (0) | 2019.09.12 |

|---|---|

| '네스트 허브 맥스' 활용법 101가지…구글이 전하는 스마트 디스플레이 활용 A-Z (0) | 2019.09.10 |

| MS, OpenAI에 10억 달러 투자…애저(Azure) AI 슈퍼컴퓨팅 기술 공동개발 (0) | 2019.07.23 |

| 수면 중 심장 상태를 모니터…워싱턴대, AI 스피커 활용 심장마비 감지 기술 개발 (0) | 2019.06.24 |

| 머신 러닝으로 위변조된 사진 판별…어도비와 UC 버클리 공동 연구 프로젝트 진행 (0) | 2019.06.17 |

| 로봇이 사람의 움직임을 예측한다…MIT, 새로운 행동 예측 알고리즘 구현 (0) | 2019.06.14 |

| AI가 원하는 스타일의 옷을 찾아준다…아마존, 의류 쇼핑 도우미 스타일스냅 공개 (0) | 2019.06.07 |

| AI 번역이 ‘직구’ 판매량을 늘린다…이베이 데이터 활용한 연구 논문 발표 (0) | 2019.05.16 |